“L’intelligenza è ciò che ci rende umani, e l’AI è un’estensione di tale qualità.”

(Yann LeCun, informatico e direttore scientifico del settore AI di Meta)

Nel precedente articolo abbiamo definito l’Intelligenza Artificiale come l’inter-disciplina dedicata allo sviluppo macchine intelligenti, ma come è nata questa disciplina?

Quali sono stati gli sviluppi e le evoluzioni che l’hanno trasformata in uno dei motori della quarta rivoluzione industriale a cui stiamo assistendo?

Gli albori

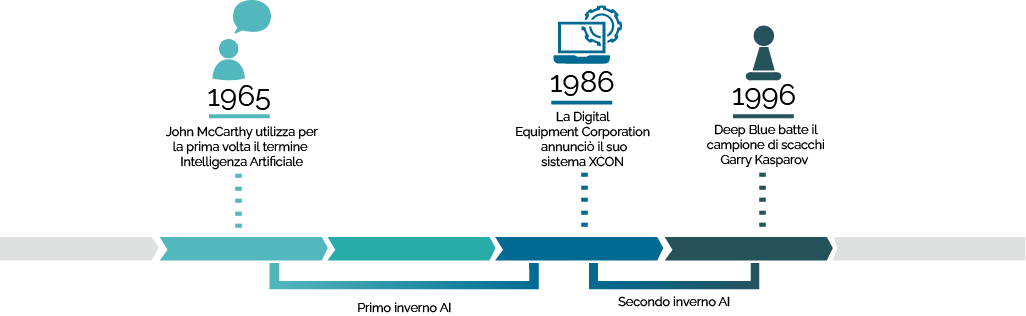

Il termine “Intelligenza Artificiale” venne utilizzato per la prima volta dall’informatico John McCarthy nel 1956, che la definì come “[…] la scienza di creare ed ingegnerizzare macchine intelligenti e in particolar modo programmi informatici intelligenti.”.

I principi fondanti dell’AI, però, erano già noti qualche anno, grazie alle idee avanguardiste di nomi noti quali Alan Turing, Warren McCulloch e Walter Pitts.

Nel 1936 Alan Turing mise a punto il concetto di Macchina di Turing, una macchina teorica antesignana dei computer moderni fondamentale per formalizzare modelli matematici in algoritmi, valutandone aspetti quali complessità e calcolabilità.

Nel 1943 McCulloch e Pitts, invece, gettarono le basi dell’odierna Intelligenza Artificiale introducendo un modello matematico realizzato per emulare il funzionamento del cervello umano.

L’unità di calcolo fondamentale di questo modello è il neurone artificiale che tramite una stimolazione esterna (tipicamente il passaggio di un flusso di dati) può essere “acceso” o “spento” al fine di eseguire un calcolo il cui risultavo viene propagato ai neuroni artificiali circostanti.

Il primo boom e il primo flop

Trascinata dall’entusiasmo, la comunità scientifica e le grandi aziende informatiche dell’epoca (prime tra tutte l’IBM) si concentrarono sullo sviluppo del modello di McCulloch e Pitts al fine di ottenere dei programmi capaci di risolvere qualsiasi problema fosse loro posto.

Tale entusiasmo però si spense in fretta a causa delle limitazioni legate alle capacità di calcolo dei computer dell’epoca: già verso la fine degli anni ’60 i ricercatori in ambito AI dovettero ammettere che i tempi non erano ancora sufficientemente maturi per l’adozione in ambito industriale di algoritmi di intelligenza artificiale.

Successivamente a questa prima ondata di entusiasmo relativa all’AI, la ricerca passò in sordina rimanendo legata ad ambiti prettamente accademici.

Questa fase di declino venne chiamata “Primo Inverno AI”e durò fino alla prima metà degli anni ’80, quando i tempi divennero finalmente maturi affinché l’Intelligenza Artificiale potesse cominciare a essere applicata (sebbene lentamente) in ambito industriale.

Il secondo boom e il secondo flop

Il secondo boom dell’Intelligenza Artificiale si verificò soprattutto grazie allo sviluppo dei cosiddetti sistemi esperti, ossia programmi capaci di rispondere a domande e di risolvere problemi relativi a un certo dominio applicativo grazie a una serie di regole logiche derivate dalla conoscenza di esperti di tale dominio.

I sistemi esperti vennero principalmente utilizzati in ambiti quali l’allocazione automatica di risorse e l’automazione di determinati task; nel 1986 la Digital Equipment Corporation annunciò che il loro sistema esperto XCON (eXpert CONfigurer) era in grado di far risparmiare loro 40 milioni di dollari l’anno configurando in modo automatico gli ordini per nuovi computer richiesti all’azienda.

Anche questa seconda ondata di entusiasmo però si spense presto: l’Intelligenza Artificiale era ancora qualcosa di troppo elitario e di poco accessibile dando inizio così al “

Secondo inverno AI”.

L’evento che porterà di nuovo la “primavera” in questo ambito si verificò – non senza una certa ironia da parte del caso – in pieno inverno.

Il terzo boom: da Deep Blue ai giorni nostri

Il 10 febbraio 1996 è senza dubbio una data significativa per il mondo dell’AI: a Philadelphia il Gran Maestro e Campione Mondiale di scacchi in carica Garry Kasparov, dopo 40 mosse, si arrende al suo avversario.

La cosa che rese questo evento così importante non fu la sconfitta di Kasparov, ma il fatto che l’avversario non è era umano : la celebre vittoria fu opera del supercomputer della IBM Deep Blue, pensato e realizzato al solo scopo di battere i più grandi maestri di scacchi.

Sebbene Kasparov riuscì a rovesciare il risultato nelle cinque partite successive con tre vittorie e due patte, il match del 10 Febbraio ha il grande merito di aver fatto conoscere l’Intelligenza Artificiale (relegata fino a quel momento ad essere solamente una tematica da libri di fantascienza) al grande pubblico, riaccendendo così l’entusiasmo del mondo industriale per questo campo.

La diffusione di Internet, la crescente accessibilità di computer sempre più veloci e l’avanzamento nella ricerca stessa sono tutti fattori che hanno portato all’adozione in sempre più ambiti e sempre più di massa dell’Intelligenza Artificiale.

La nascita di “specializzazioni” dell’AI come il Machine Learning (nato dall’idea del neurone artificiale di McCulloch e Pitts, ma distintosi dall’Intelligenza Artificiale “classica” solo a metà degli anni ’80) e il Deep Learning (la cui nascita si colloca all’inizio degli anni duemila) hanno aperto scenari applicativi sempre più vasti per tale disciplina: dalla personalizzazione dei contenuti web alla guida autonoma, dal riconoscimento automatico di patologie a partire da immagini diagnostiche alla traduzione istantanea.

Non c’è dubbio che l’Intelligenza Artificiale si stia permeando sempre di più in tutti gli aspetti delle nostre vite.

È per questi motivi che l’Intelligenza Artificiale è definita come il motore principale della Quarta Rivoluzione Industriale, al punto che Klaus Schwab (fondatore del World Economic Forum) ha asserito che l’adozione dell’AI nei domini più vari diventerà irrefrenabile entro il 2030.

Conclusioni

In questo post abbiamo redatto una breve storia dell’Intelligenza Artificiale, dagli albori ai giorni nostri. Nel prossimo post di questo blog faremo invece un po’ di chiarezza su dei termini introdotti in questo post: spiegheremo infatti la differenza tra Intelligenza Artificiale “classica”, Machine Learning e Deep Learning.

Intelligenza artificiale: istruzioni per l’uso

In un precedente blog post abbiamo già discusso di cosa sia l’intelligenza artificiale, delle sue potenzialità e degli ambiti in...

Ma l’AI può risolvere i cruciverba?

“La parola ‘impossibile’ non è nel mio vocabolario!” (Napoleone Bonaparte) Nel post precedente di questo blog vi abbiamo...

Aipertech affiliata di Ditedi

Aipertech entra a far parte del più importante network regionale delle aziende ICT, confermandosi un'eccellenza nel campo...

DALL-E: Come funziona?

“L'arte non è ciò che vedi, ma ciò che fai vedere agli altri.”(Edgar Degas, pittore impressionista) Nell’ultimo mese ha destato...

Quantum Machine Learning: di cosa si tratta?

“La meccanica quantistica è quella disciplina misteriosa e confusa che nessuno di noi capisce veramente, ma che sappiamo...

Può un’AI diventare senziente?

“Può darsi che il nostro ruolo su questo pianeta non sia quello di adorare Dio, ma di crearlo.” (Arthur C. Clarke, scrittore,...

Intelligenza Artificiale e Metaverso

“Coloro che possono immaginare qualsiasi cosa, possono creare l’impossibile.” (Alan Mathison Turing, matematico e crittografo,...

L’Intelligenza Artificiale e l’Industria

“Come tecnologa, comprendo come l'intelligenza artificiale e la quarta rivoluzione industriale avranno un impatto su ogni...

Differenze tra Artificial Intelligence, Machine Learning e Deep Learning

“La misura dell’intelligenza è la capacità di cambiare.” (Albert Einstein, fisico) Nello scorso articolo di questo blog abbiamo...